Fotografia cyfrowa – matryca CCD

Fotografia cyfrowa powstała jako naturalna konsekwencja rozwoju technologii informatycznych i elektronicznych w drugiej połowie XX w. Fotografia, wynalazek z lat 30. XIX w., to jeden z symboli nowoczesnej epoki przemysłowej i zachodzących w niej przemian społecznych. Najlepiej wyrażał ją slogan reklamowy George’a Eastmana, wprowadzający w 1888 r. nowy aparat fotograficzny Kodak: „ty naciskasz spust migawki, my robimy resztę”. Po pierwsze, nowy aparat wyposażony był w zwijany film fotograficzny (wcześniejsze modele wymagały szklanych płyt), co otworzyło drogę do fotografii hobbystom-amatorom. Po drugie, Eastman uruchomił sieć laboratoriów, by uwolnić amatorów od trudów chemicznej obróbki zdjęć.

Rozwój fotografii

Późniejsze sto lat rozwoju fotografii polegało na konsekwentnym udoskonalaniu idei Eastmana: coraz mniejsze, tańsze i łatwiejsze w obsłudze aparaty, coraz lepsze błony fotograficzne, coraz lepsza technika laboratoryjna, a zwłaszcza możliwy dzięki rozwojowi elektroniki wynalazek automatycznych fotolabów, które odebrały pracę tradycyjnym zakładom fotograficznym. W efekcie fotografia stała się najbardziej demokratycznym hobby, w 2000 r. fotoamatorzy wykonywali 2000 zdjęć na sekundę! Dziś jednak przeżywa najbardziej radykalną od chwili powstania rewolucję.

Wynalazek CCD

Pierwsze elektroniczne komputery cyfrowe pokazały w praktyce to, o czym od lat mówili matematycy – dowolną informację można przedstawić w postaci szeregu zer i jedynek. Każdą informację, czyli tekst, dźwięk, obraz statyczny i ruchomy daje się przetłumaczyć na ciąg znaków, które może odczytać i manipulować nimi maszyna.

Pierwsze elektroniczne komputery cyfrowe pokazały w praktyce to, o czym od lat mówili matematycy – dowolną informację można przedstawić w postaci szeregu zer i jedynek. Każdą informację, czyli tekst, dźwięk, obraz statyczny i ruchomy daje się przetłumaczyć na ciąg znaków, które może odczytać i manipulować nimi maszyna.

Skorzystała z tego po raz pierwszy na szerszą skalę amerykańska agencja astronautyczna NASA w latach 60. ubiegłego stulecia. Inżynierowie przygotowujący lot na Księżyc w ramach projektu Apollo musieli poradzić sobie z analizą tysięcy fotografii powierzchni naszego naturalnego satelity dostarczonych przez próbniki Ranger. Robert Nathan, inżynier z Jet Propulsion Laboratory, stwierdził, że jedynym sposobem wywiązania się z zadania jest zaprzęgnięcie do pomocy komputerów. Na narodziny prawdziwej fotografii cyfrowej trzeba jednak było jeszcze poczekać kilka lat, do czasu wynalezienia elektronicznego odpowiednika światłoczułego filmu.

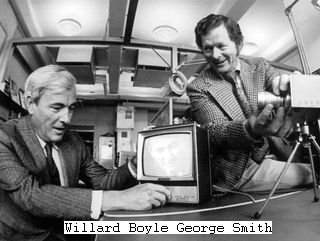

Wideofon i CCD

Przełom nastąpił w tym samym 1969 r., kiedy Neil Armstrong i Edwin Buzz Aldrin wylądowali na Księżycu. Willard Boyle i George E. Smith pracowali wtedy w Laboratoriach Bella należących do koncernu telekomunikacyjnego AT&T. W owym czasie były one największą wylęgarnią wynalazków na świecie, a obaj naukowcy ślęczeli nad projektem wideofonu, czyli telefonu zdolnego do przekazywania obrazu (Picture-phone).

Elektroniczna rejestracja obrazu

Elektroniczna rejestracja obrazu

Podstawowa trudność polegała na opracowaniu elektronicznego elementu światłoczułego, który zamieniałby obraz na impulsy elektroniczne. Rozwiązaniem był odpowiednio zaprojektowany materiał półprzewodnikowy, który umożliwiał bezpośrednią elektroniczną rejestrację obrazu. W 1970 r. nowy element o nazwie CCD (ang. charge-coupled device) zainteresował inne firmy elektroniczne, m.in. Fairchild Semiconductor zaprezentował pierwsze komercyjne urządzenie do elektronicznej rejestracji obrazu wykorzystane w 1974 r. do zdjęć astronomicznych. Rok później jakość CCD była już na tyle dobra, że można było je zastosować w kamerach telewizyjnych i skanerach.

Bariery, zanim fotografia cyfrowa podbiła rynek

Wiele lat upłynęło, zanim cyfrowa fotografia i wideo podbiły rynek. Ich upowszechnienie hamowały trzy bariery. Po pierwsze, wielkie koszty mocy obliczeniowych potrzebnych do przetwarzania olbrzymich ilości informacji powstających podczas rejestracji obrazów. Dopiero wynalazek mikroprocesora, a właściwie zapoczątkowana przezeń rewolucja komputerów osobistych, spowodowały, że dziś każdy posiadacz domowego peceta dysponuje większą mocą obliczeniową niż superkomputery używane 20 lat temu w amerykańskiej armii i wytwórniach filmowych w Hollywood. Po drugie, barierą była rozdzielczość CCD, czyli liczba elementów obrazu, jaką to urządzenie może zarejestrować na jednostce powierzchni (im większa rozdzielczość, tym lepsza jakość zdjęcia).

Pierwszy elektroniczny aparat fotograficzny

Pierwszy elektroniczny, choć jeszcze nie cyfrowy, aparat fotograficzny Mavica firmy Sony z 1981 r. umożliwiał rejestrację 720 tys. pikseli, a zdjęcie było zapisywane na dyskietce (piksel to podstawowy fragment obrazu – dziś nawet aparaty w telefonach komórkowych oferują większą rozdzielczość).

W końcu – liczył się koszt pamięci elektronicznej potrzebnej do przechowywania wielkich ilości informacji. Dla przypomnienia, dyski twarde w pierwszych komputerach osobistych na początku lat 80. miały pojemność 10-20 MB, co wystarczało do zarejestrowania jednego zdjęcia wysokiej rozdzielczości. Równolegle ze wzrostem pojemności pamięci komputerowych matematycy pracowali nad metodami kompresji, czyli zmniejszania ilości informacji potrzebnej do zapisania obrazu.

W rezultacie w 1992 r. powstał popularny standard kompresji JPEG, stosowany dziś powszechnie w fotografii cyfrowej.

Masowa cyfryzacja

Początkowe trudności nie powstrzymywały jednak inżynierów. W 1986 r. amerykański Kodak, potentat na rynku fotograficznym, ogłosił, że pokonał symboliczną barierę rozdzielczości CCD opracowując element zdolny do zarejestrowania 1,4 min pikseli.

Cyfrowy aparat fotograficzny

Cztery lata później ta sama firma zaproponowała system archiwizowania cyfrowych fotografii na płytach CD o nazwie Photo CD, który rozwiązywał problem wysokich kosztów i niedostatecznej pojemności twardych dysków. W końcu w 1991 r. na rynku pojawił się pierwszy profesjonalny cyfrowy aparat fotograficzny Kodak DCS-100 (wykorzystujący konstrukcję aparatu Nikon F-3), przeznaczony dla fotoreporterów.

Umożliwiał fotografowanie z rozdzielczością 1,3 min pikseli i kosztował ponad 10 tys. dol. W 1994 r. koncern komputerowy Apple rozpoczął sprzedaż aparatu QuickTake 100 przeznaczonego na masowy rynek – cacko za ok. 1000 dol. fotografowało z rozdzielczością 640 na 480 pikseli.

Rynek konsumencki rozkręcił się na dobre dopiero po 2000 r., a cyfrowo-fotograficzną rewolucję dopełniła w 2006 r. fińska Nokia, wprowadzając na rynek telefon komórkowy N-93, nazywany przez producenta „komputerem multimedialnym”. Niewiele w tym określeniu przesady, bo rzeczywiście telefon ten umożliwiał fotografowanie z rozdzielczością 3 min pikseli, kręcenie filmów wideo o bardzo dobrej jakości i natychmiastowe dzielenie się efektami pracy z resztą świata.

Pytanie o rzeczywistość

Możliwości cyfrowej rejestracji i przetwarzania obrazu fascynują nie tylko hobbystów, lecz także środowisko, w którym te technologie powstały. Dla uczonych, począwszy od lekarzy badających wnętrze ludzkiego ciała po astronomów przyglądających się odległym gwiazdom, nowe technologie pracy z obrazem są niezbędnym codziennym narzędziem badawczym.

Cyfrowy zapis obrazu, a zwłaszcza łatwość, z jaką się nim manipuluje w komputerze, wywołuje także pytania o wartość dokumentacyjną elektronicznych zdjęć. Jak bowiem udowodnić, że nie zostało ono sfałszowane, skoro fachowiec potrafi zmodyfikować oryginał bez pozostawienia śladów? Wcześniej manipulacje też były możliwe, pozostawał jednak fizyczny oryginał w postaci naświetlonej taśmy, gdzie prawda była utrwalona w srebrze.

Prawdziwe zdjęcie cyfrowe

Problem zyskał spektakularną ilustrację w 1982 r., gdy na okładce magazynu „National Geographic” grafik ze względów kompozycyjnych podretuszował zdjęcie egipskich piramid. Niektórzy z czytelników uznali ten czyn za sprzeniewierzenie się prawdzie, co zmusiło redakcję do przeprosin.

Kwestia relacji fotografii do rzeczywistości od dawna intrygowała filozofów. Walter Benjamin pisał przed II wojną światową w słynnym eseju „Dzieło sztuki w dobie reprodukcji technicznej”, że wynalazek fotografii „przemysłowej” umożliwiający reprodukcję pozbawia sensu pojęcie oryginału. W efekcie dzieło sztuki zatraca swoistą aurę, wynikającą właśnie z jego niepowtarzalności. Technologie cyfrowe doprowadzają do sytuacji, w której obraz całkowicie odrywa się od swojej materialnej podstawy i istnieje wyłącznie w postaci znaku. Cyfrowym znakiem można zaś z łatwością manipulować, kopiować go w nieskończoność i bez problemu dystrybuować za pomocą globalnych medialnych sieci.

Jak działa CCD?

- Światło przechodzi przez obiektyw i przesłonę aparatu.

- Migawka otwiera się umożliwiając naświetlenie elementu CCD. Ma on filtr rozdzielający światło na czerwień, zieleń i niebieski (element CCD zawiera tysiące pikseli, czyli najmniejszych punktów światłoczułych).

- Pod wpływem światła piksel produkuje ładunek elektryczny, którego energia zależy od intensywności światła.

- Wielkość ładunku jest„tłumaczona” na kod dwójkowy, zrozumiały dla mikroprocesora.

- Suma informacji z pikseli zapisywana jest w postaci pliku, który rejestrowany jest w elektronicznej pamięci.